AIがWebサービスの中心となる今、Pythonサーバーはその柔軟性とAIライブラリとの親和性から、最も扱いやすい基盤として注目されています。FastAPIやFlaskを用いれば、推論レイヤーを自然に組み込みながら、高速で拡張しやすいAPIを構築でき、モデル更新や負荷増大にも対応しやすい点が大きな強みです。Pythonサーバー×AIは、開発効率だけでなくサービス体験そのものを高める実践的な組み合わせとして広く採用が進んでいます。

- 1. 1. なぜ今、Pythonサーバー×AIが「Webの基盤」になりつつあるのか

- 2. 2. AI統合型Webサービスのアーキテクチャ層を分解する

- 3. 3. Pythonサーバーで採用されるAI推論設計パターン

- 3.1. パターン1:同一サーバー内にモデルを配置

- 3.2. パターン2:AI推論マイクロサービスを分離

- 3.3. パターン3:外部AI APIをプロキシ化

- 3.4. パターンの使い分け

- 4. 4. FastAPI/FlaskによるAI推論APIの実装戦略

- 5. 5. 推論高速化・スケール戦略(CPU/GPU、バッチ処理、キャッシュ)

- 5.5. モデルの軽量化

- 5.6. 推論のバッチ処理

- 5.7. キャッシュ(Redis)

- 5.8. 非同期キュー(Celery / RabbitMQ)

- 6. 6. 運用段階で不可欠となるMLOpsの観点

- 6.9. モデルバージョン管理

- 6.10. モニタリング

- 6.11. 影響評価の自動化

- 7. 7. Pythonサーバー×AIが生み出す新しいWeb価値

- 7.12. ユーザー毎に変化するUX

- 7.13. 業務効率の自動化

- 7.14. 新しいビジネスモデル

1. なぜ今、Pythonサーバー×AIが「Webの基盤」になりつつあるのか

AIは単なる機能ではなく、ユーザー体験そのものを左右するサービスの中核要素になりました。しかし、AIモデルをWebに統合する際には次の課題が必ず発生します。

・モデルの推論速度をどう最適化するか

・モデルの再学習や更新をどう安全に行うか

・フロントエンドの大量リクエストを受け止めるスケール戦略

・ユーザーデータを扱うセキュリティやプライバシー問題

これらの要件に自然に対応できる言語とフレームワークの組み合わせがPythonサーバー×FastAPI/Flask です。

なぜか?

・AIライブラリとの親和性が圧倒的

・推論コード・APIコードが同じ言語で書ける

・Pythonエコシステム全体が「AI前提」に進化している

・小規模・高速・柔軟なAPI構築ができ、モデル別にマイクロサービス化しやすい

単に「PythonがAIに強い」からではなく、アーキテクチャの分割・更新・再配置が時代の要件と一致していることが本質です。

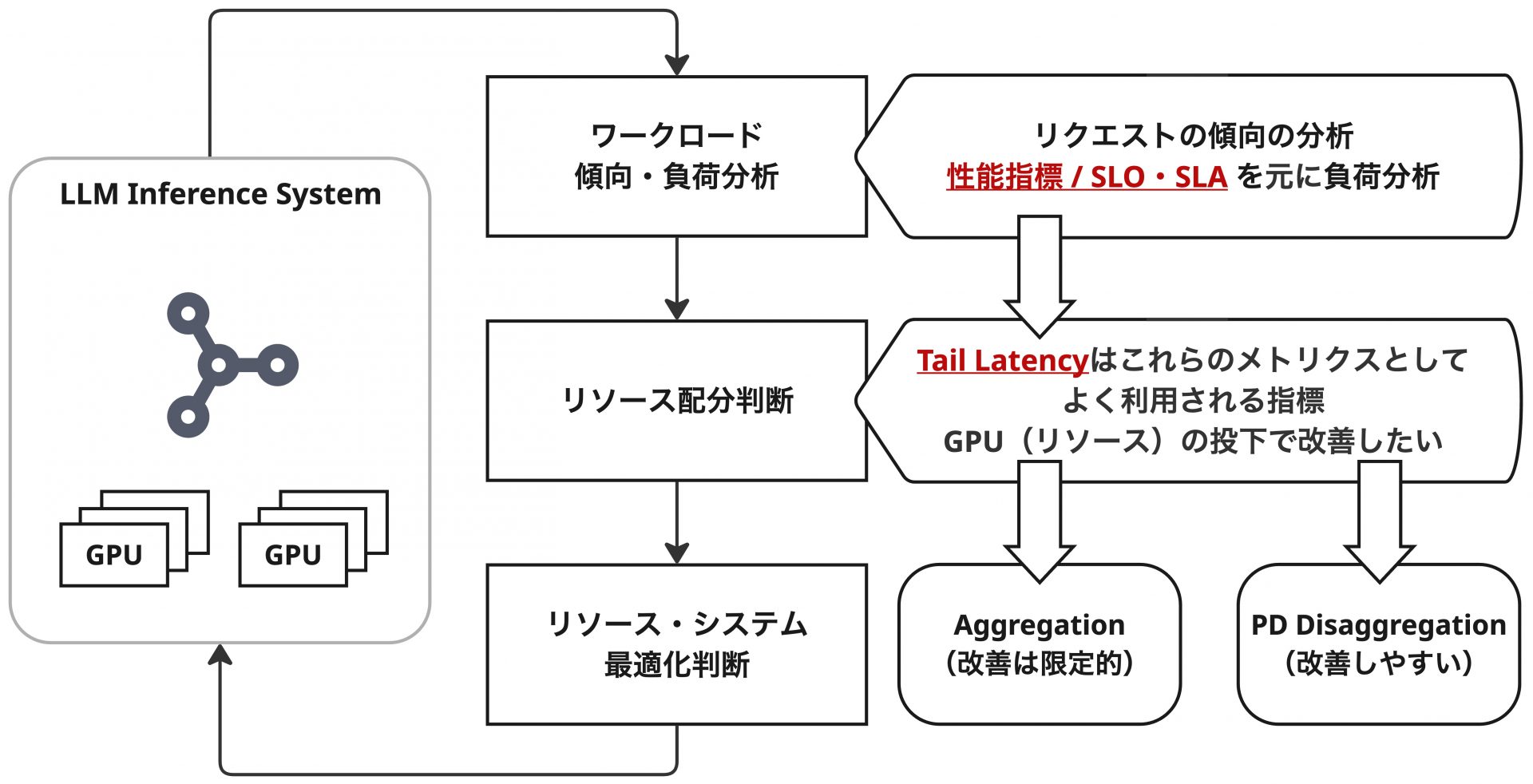

2. AI統合型Webサービスのアーキテクチャ層を分解する

AIを使ったWebサービスは、従来のWebアーキテクチャと異なり「推論レイヤー」が明確に独立するのが特徴です。

一般的な分離構造

- APIフロント層(FastAPI / Flask) リクエスト受付、認証、ルーティング

- 推論レイヤー(AI Model Layer) モデル読み込み、前処理、推論、後処理

- モデル管理層(Model Registry / Versioning) モデルファイルのバージョン管理

- データストレージ層(RDB / NoSQL) 推論結果やログ、ユーザーデータ

- オーケストレーション層(Docker / Kubernetes) スケーリング・更新ロールアウト

AIサービスはこの「層構造」のバランスが崩れると性能と安定性を失います。Pythonサーバーは、この層の連携を自然に実現しやすいのです。

3. Pythonサーバーで採用されるAI推論設計パターン

パターン1:同一サーバー内にモデルを配置

小〜中規模で最も採用される構成。読み込み高速、シンプル、開発スピードが早い。

パターン2:AI推論マイクロサービスを分離

高負荷システムで採用。サーバーを水平スケール、モデルの切り替えが容易。

パターン3:外部AI APIをプロキシ化

外部AI(クラウドAI・LLM等)を統合し、Pythonサーバーが「ゲートウェイ」となる構成。

パターンの使い分け

・低レイテンシ重視 → パターン1

・スケール・モデル切替重視 → パターン2

・最新AI活用・学習不要 → パターン3

4. FastAPI/FlaskによるAI推論APIの実装戦略

FastAPIの利点は以下。

・非同期処理(async)

大量アクセスにも対応しやすい。

・Pydanticによる厳密なデータ検証

AI入力前の前処理を堅牢にできる。

・自動ドキュメント生成(OpenAPI)

外部連携・社内チームの開発速度が大幅に向上。

Flaskは柔軟性が高く、カスタム構成や既存システム統合に強い。用途に応じてFastAPI → 推論API中心、Flask → アプリ全体構築と分けるケースが多い。

5. 推論高速化・スケール戦略(CPU/GPU、バッチ処理、キャッシュ)

AI推論で最も問題になるのは 応答速度と負荷管理。Pythonサーバーで一般的な改善戦略は次のとおり。

モデルの軽量化

・量子化(quantization)

・モデル圧縮

・ONNX Runtimeで最適化

推論のバッチ処理

複数リクエストをまとめてモデルに投入。GPU環境では効果が大きい。

キャッシュ(Redis)

同様の入力が来るサービスでは圧倒的な効果。画像・文章要約などで特に有効。

非同期キュー(Celery / RabbitMQ)

重いモデルや長時間処理を分離して安定化。Pythonサーバーはこれらを統合しやすく、実装負荷と効果のバランスが良い。

6. 運用段階で不可欠となるMLOpsの観点

AI統合サービスでは、運用フェーズでの対応が品質を左右します。

モデルバージョン管理

更新したモデルが従来より劣化することは普通に起こるため、ロールバック可能なモデル管理 が必須。

モニタリング

・推論時間

・モデルのドリフト

・ユーザー導線との相関

などを可視化。

影響評価の自動化

更新後のモデルが業務KPIにどのように影響したかを継続評価。

Pythonサーバーは監視・ロギングツールとの統合が容易で、運用段階の対応速度も高い。

7. Pythonサーバー×AIが生み出す新しいWeb価値

ユーザー毎に変化するUX

・パーソナライズ

・行動分析

・自動生成コンテンツ

業務効率の自動化

バックオフィスから製造業まで幅広い領域で効果を発揮。

新しいビジネスモデル

AIを「機能」ではなく「価値そのもの」として扱うサービスが増え、Webサービスの本質が変わりつつある。

Pythonサーバーはこの変革を最も自然に支える基盤です。

Pythonサーバー×AIは、高精度な推論処理、スケールのしやすさ、運用のしなやかさを兼ね備え、現代のWebサービスに必要な要件を自然に満たします。AIが標準化する時代、モデルの活用とWeb提供を同一環境で扱えるPythonの利点は大きく、サービス品質と開発スピードの両立に直結します。これからのWeb開発では、Pythonサーバーを中心にAIを統合する設計が確実に主流となっていくでしょう。

著者: Trang Admin

キーワード: Pythonサーバー, AI統合, AI推論API, モデルデプロイ, FastAPI, Flask, Webアーキテクチャ, MLOps

Devworksは、ベトナムIT人材と求人を繋がりプラットフォームであり、日本国内人材不足問題を解決し、採用コストも節約できるよう支援します。 迅速かつ効率的かつ費用対効果の高い採用プラットフォームをご検討されている方々はぜひ一度ご相談ください。

IT 業界で最大 400,000 人の人々を接続します。

パートナーを見つけるコストを節約します。

小さなご要望でも、いつでもオンラインでお申し込みください。

お問い合わせ:

メール: hello@devworks.jp

作品一覧

関連記事

Microservices時代の核心に迫る:Pythonサーバーで構築する柔軟・高拡張アーキテクチャの実践知

Microservicesへの移行が進む背景には、サービスを「変化し続ける前提」で設計しなければならない現代のビジネス構造があります。その中でPythonサーバーは、軽量フレームワークを中心に小さなサービスを迅速かつ独立して構築できる性質を持ち、境界設計とスケール戦略の両面でMicroservicesの思想と深く噛み合います。FastAPIやFlaskが提供する柔軟で直感的な設計は、複雑化する分散アーキテクチャの中で安定した基盤として機能し、チームの生産性とサービス品質を同時に高める役割を果たします。